CONTENT MODERATION

Analítica de contenido de usuarios: moderando el abuso con API de análisis de texto

Es una tecnología de comprensión del lenguaje natural (NLU) con un enfoque en detectar contenido abusivo y satisfacer las necesidades de la tecnología legal y regulatoria.

Esta herramienta está diseñada para

identificar y analizar diversos tipos de contenido problemático, como el ciberacoso, los ataques personales, el discurso de odio, los avances sexuales, las profanidades ocultas, la actividad criminal y más. Lo que la distingue es su capacidad para manejar el lenguaje que se encuentra en las redes sociales, que a menudo es vulgar, carece de gramática adecuada y contiene jerga específica. La tecnología ha sido desarrollada desde cero para adaptarse a este tipo de contenido, lo que le permite comprender y analizar de manera efectiva el lenguaje utilizado en las plataformas de redes sociales y otros entornos en línea.

Redes y plataformas

Empresas de redes sociales y plataformas en línea que deseen moderar el contenido generado por los usuarios para evitar el abuso y mantener un ambiente seguro y respetuoso para los usuarios

Administraciones y ONGs

Organizaciones sin fines de lucro y gobiernos que buscan supervisar el contenido en línea para detectar y prevenir la difusión de discursos de odio, acoso y otros tipos de contenido inapropiado

Desarrolladores y Empresas

Empresas que operan en sectores altamente regulados, como el financiero o el de la salud, que necesitan cumplir con ciertos estándares éticos y legales en cuanto a la gestión de datos y la prevención del uso de contenido inapropiado

Prueba

- Hasta 5.000 peticiones

- Hasta 10 hits/min

Start

- Hasta 100.000 peticiones

- Hasta 120 hits/min

Pro

- Hasta 1.500.000 peticiones

- Hasta 120 hits/min

Business

- Hasta 2.500.000 peticiones

- Hasta 2000 hits/min

¿Necesitas ayuda para la integración?

Solicita la asistencia de nuestro partner integrador y nos ocuparemos de todo

Combina esta tecnología con:

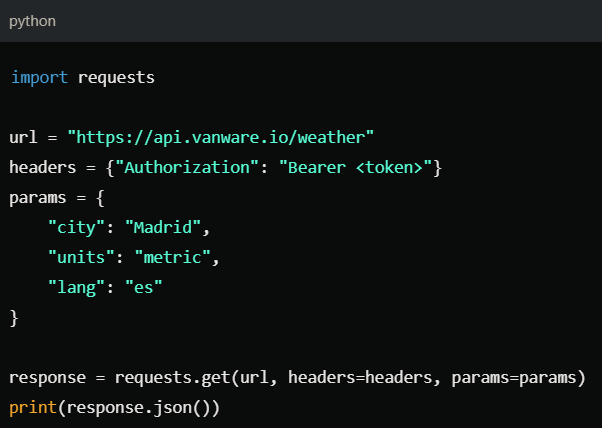

Snippets de código